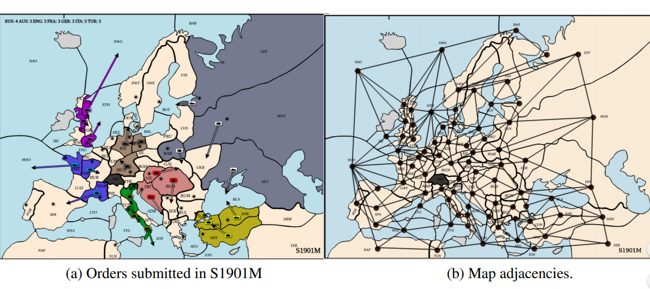

Quizás conozcas el juego de mesa Diplomacia, o 1914. El tablero muestra el mapa de Europa durante la primera guerra mundial, hay ejércitos y flotas con los que puedes conquistar regiones y defender tus posesiones.

Lo más importante de este juego es que a diferencia del Risk o el TEG, no se lanzan dados, sino que las batallas son ganadas por el bando que más unidades pone en juego en una región.

El truco es que los jugadores escriben las órdenes para sus ejércitos y pueden conversar entre sí en secreto para coordinar sus movimientos. Luego todo se resuelve de forma simultanea.

Un nuevo desafío

Diplomacia es el nuevo desafío para DeepMind, la inteligencia artificial que ya ha jugado al Ajedrez, al Go, Starcraft 2 y Montezuma’s Revenge. Los desarrolladores creen que el juego de mesa ofrece una nueva oportunidad de mejora, la capacidad para “negociar” y coordinar acciones con otros individuos.

Ponemos negociar entre comillas porque DeepMind juega una variante de este juego de mesa en la que no se permiten las comunicaciones entre los jugadores.

El juego le exige a los agentes de IA que sopesen los intereses individuales y los grupales y sepan cuánto debe sacrificar de sus propios objetivos para conseguir un resultado favorable.

Los agentes deben ser también capaces de entender las ambiciones de los otros jugadores, que pueden ser aliados hoy y enemigos mañana (es decir el próximo turno).

El esquema de decisión de los agentes se basa en el aprendizaje a través de ejemplos de mejores respuestas. Con cada interacción DeepMind crea un set de datos de juegos con las acciones elegidas previamente y luego busca una opción que permita obtener un beneficio mayor.

Los agentes de DeepMind no fueron muy exitosos, pero mostraron una mejora respecto a los entrenados bajo supervisión humana.

DipNet es un trabajo que antecede al de los desarrolladores de Google, pero utiliza un sistema de entrenamiento más supervisado.

El problema de la confianza

El diseño del juego impide que un jugador pueda alcanzar sus objetivos tan solo con sus propias acciones. El éxito es siempre el resultado de la cooperación. Pero al mismo tiempo la posibilidad de una traición siempre existe cuando el escenario cambia.

Los desarrolladores de DeepMind creen que Diplonacia puede utilizarse para estudiar el surgimiento del comportamiento manipulativo y las formas en que puede mitigarse. También serviría como caso de estudio para el establecimiento y el mantenimiento de la confianza en las alianzas.

Los resultados podrían aplicarse a los negocios, la economía, la logística y otros ámbitos similares.