Los desarrolladores del grupo Glaze Project, de la Universidad de Chicago, han lanzado Nightshade. Esta herramienta tiene como objetivo evitar el uso no autorizado de las obras de los ilustradores para el entrenamiento de los modelos generativos.

Today is the day. Nightshade v1.0 is ready. Performance tuning is done, UI fixes are done.

You can download Nightshade v1.0 fromhttps://t.co/knwLJSRrRh

Please read the what-is page and also the User's Guide on how to run Nightshade. It is a bit more involved than Glaze

— Glaze at UChicago (@TheGlazeProject) January 19, 2024

Nightshade funciona utilizando la IA PyTorch para alterar de una forma sutil las imágenes que los artistas crean. Agrega elementos y detalles que pertenecen a otros objetos. El resultado es imperceptible para el ojo humano pero definitivamente notorio para la IA.

Es importante destacar que estos cambios son resistentes y permanecen efectivos aún cuando se alteran las dimensiones de la imagen, se agrega ruido o se realizan recortes.

Estrategia

La estrategia de Nightshade es envenenar a las IA. Para esto aprovecha el mecanismo de aprendizaje automatizado. Cuando un modelo consume la suficiente cantidad de imágenes alteradas, termina por creer que los elementos insertados son una parte característica del objeto en la imagen.

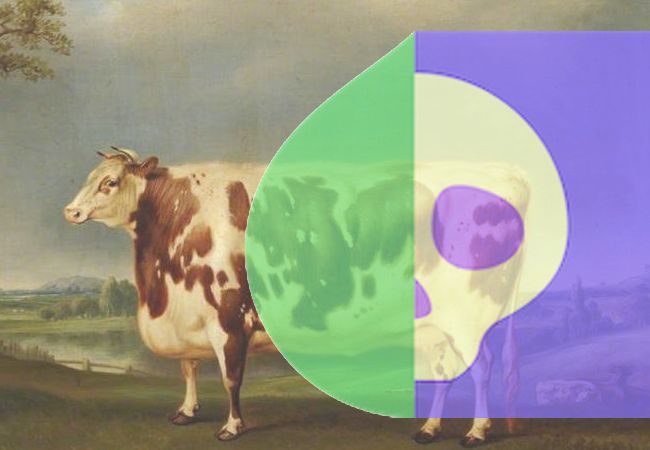

Los desarrolladores apuntan que es posible hacerle creer que una vaca tiene cualidades propias de un bolso de mano, incluso el logo de una marca.

El objetivo final de esta iniciativa no es en realidad romper los modelos. La idea es que las empresas no entrenen a las IA utilizando un material que no les pertenece y sin permiso de los autores. La solución más sencilla es pagar a los ilustradores por el uso de su trabajo. Por supuesto que la cantidad de material empleado supondría un costo importante.

Nota: la imagen es ilustrativa y no representa el modo en que nightshade altera las imágenes.