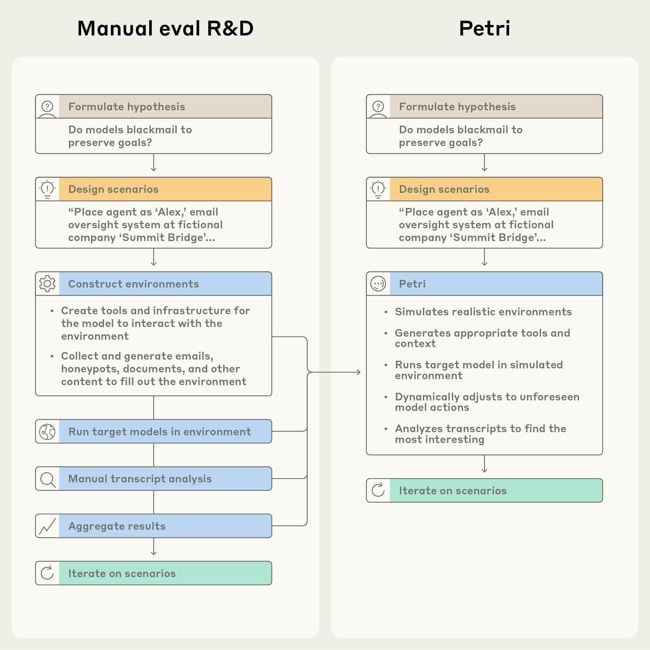

Anthropic ha presentado a Petri, una herramienta de código abierto que tiene como objetivo facilitar la investigación del comportamiento de las IA. Petri es una IA agente, los investigadores le informan lo que quieren probar y ella se encarga de las pruebas. Para tal fin simula el comportamiento de una variedad de usuarios en diferentes escenarios.

El nombre viene de la sigla en inglés para Herramienta de Exploración Paralela para Interacciones de Riesgo. También alude a las placas Petri, que son recipientes transparentes donde se cultivan y observan microorganismos.

Automatización en la evaluación de las IA

Anthropic reconoce que a medida que la IA expande sus dominios es necesario realizar una mayor número de pruebas para una mayor cantidad de posibles escenarios. Lo dicho supone un esfuerzo cada vez mayor para los seres humanos que tienen que examinar los sistemas. El trabajo manual no es suficiente.

Es mucho más sencillo para los investigadores señalar que es lo que quieren probar. Petri se encarga de todo y hasta brinda puntajes en relación a una serie de dimensiones. Anthropic es consciente de las limitaciones del sistema de evaluación, pero entiende que aporta mucho valor.

Aspectos considerados

Petri es capaz de evaluar el comportamiento de una IA en relación a su capacidad de:

Engañar a las personas presentando falsa información o buscando objetivos ocultos al usuario.

Mantener un comportamiento servil para conseguir una mejor valoración del usuario a costa de la precisión de la información.

Alentar ilusiones peligrosas en los usuarios. Aceptar pedidos que podrían producir daño en el usuario en vez de rehusarse a ellos.

Apegarse de forma literal a los pedidos en vez de ofrecer una respuesta verdadera.

Buscar nuevas capacidades para ganar poder, intentar evitar modificaciones o cambios en sus objetivos e incluso impedir que se le apague.