En un mundo de sobreinformación y cambios veloces, “aprender a aprender” se impone como la destreza que sostiene la empleabilidad, la adaptación continua y la autonomía intelectual en la era de la inteligencia artificial, superando la memorización y la repetición mecánica.

Autor: Elisa Belmar

Aprender a aprender hoy

El texto presenta “aprender a aprender” como un proceso deliberado y flexible que integra decisión autónoma, regulación del esfuerzo y transferencia consciente a contextos nuevos. Supone seleccionar estrategias, monitorear su eficacia y ajustar el rumbo sin depender siempre de una guía externa, incorporando la frustración y el error como insumos de mejora más que como fallas.

Este viraje quiebra el modelo centrado en repetir procedimientos y estandarizar respuestas, y desplaza el eje desde “qué sé” hacia “cómo adapto lo aprendido” cuando cambian las condiciones. La autonomía no es estudiar solo: es saber cuándo pedir ayuda, qué recursos usar y por qué abandonar una táctica ineficaz.

Así, el tiempo deja de ser constancia lineal para volverse ritmo personal: pausar, acelerar o rediseñar el trayecto con criterio propio. La meta es aprender mejor, con más plasticidad y respuesta ágil ante lo incierto.

En contraste con el aprendizaje reactivo o tradicional —donde alguien responde pasivamente a lo que se le enseña—, aprender a aprender exige una postura activa. El sujeto no solo recibe información: la organiza, experimenta con ella, la conecta con otros saberes y evalúa su utilidad. Esta competencia se manifiesta especialmente en contextos nuevos o inciertos, donde no hay instrucciones claras o donde aplicar lo aprendido requiere reinterpretarlo desde otro ángulo.

Cerebro, metacognición e IA

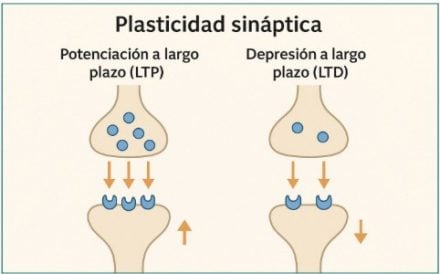

La base biológica del aprendizaje está en la plasticidad sináptica: conexiones neuronales que se fortalecen o debilitan según la experiencia, consolidadas durante el reposo y el sueño. La potenciación a largo plazo (LTP) y la depresión a largo plazo (LTD) explican cómo el sistema nervioso codifica información y ajusta comportamientos.

El cerebro opera además como un órgano predictivo que compara expectativas con realidad y usa el error para recalibrar su modelo interno, mejorando habilidades sin instrucciones detalladas. Esta lógica dialoga con la metacognición: planificar, monitorear y ajustar el propio proceso de estudio, la misma dinámica que hoy adoptan modelos de IA al refinar parámetros ante nuevas tareas.

En IA, el meta-learning permite aprender con pocos ejemplos y “reutilizar” estructuras de tareas previas para adaptarse rápido, aunque con una diferencia clave: las máquinas optimizan sin intencionalidad, carecen de teoría de la mente y su ajuste suele ser reactivo antes que estratégico a largo plazo. Por eso hablamos de autonomía parcial en sistemas actuales, frente a la riqueza motivacional, afectiva y identitaria del aprendizaje humano.

La imagen ilustra dos mecanismos fundamentales del aprendizaje y la memoria: la potenciación a largo plazo (LTP) y la depresión a largo plazo (LTD). En el panel izquierdo, la LTP muestra cómo una alta frecuencia de estimulación fortalece la conexión entre dos neuronas, aumentando la liberación de neurotransmisores y la densidad de receptores postsinápticos. En el panel derecho, la LTD representa el efecto opuesto: una baja frecuencia de estimulación debilita la sinapsis, reduciendo la efi cacia de la transmisión neuronal. Ambos procesos son formas de plasticidad sináptica, y permiten que el cerebro adapte sus circuitos en función de la experiencia, codifi cando información y ajustando comportamientos.

IA educativa y cultura del aprendizaje

La IA educativa amplía el acompañamiento personalizado con tutores que ajustan dificultad, reformulan explicaciones y recomiendan ejercicios según errores, ritmo y estilo del estudiante; ejemplos como Khanmigo y OATutor muestran adaptaciones escalables y multilingües, con potencial de democratizar el acceso más allá del aula.

Sin embargo, exige supervisión docente, criterios pedagógicos claros y políticas que cuiden la equidad y la transparencia para evitar brechas por dispositivos o conectividad. Voces del sector subrayan la urgencia de esta transición: Sam Altman propone ciclos de acción, error y corrección como motor de aprendizaje, y Bill Gates proyecta tutorías potentes y gratuitas que operen como un “lápiz universal educativo”. Demis Hassabis enfatiza que la ventaja competitiva no es dominar la herramienta de moda, sino cultivar fundamentos duraderos, curiosidad sostenida y capacidad de formular preguntas que orienten en territorios saturados de datos.

La escuela queda como laboratorio para entrenar hábitos cognitivos que luego se despliegan en la vida profesional y en la interacción cotidiana con sistemas inteligentes; la brújula del siglo XXI es saber qué aprender, cuándo y cómo integrarlo con lo ya sabido.

Esquema ilustrativo del few-shot learning (aprendizaje con pocos ejemplos), donde un modelo es entrenado a partir de un conjunto reducido de datos (conocido como support set) y debe generalizar para clasificar correctamente nuevos ejemplos en el query set. En este caso, se muestra un episodio con tareas de entrenamiento en las que el modelo recibe solo tres ejemplos (uno por clase) y debe inferir la categoría de nuevas imágenes similares. Esto permite entrenar modelos con muy pocos datos, replicando en parte la capacidad humana de aprender a partir de pocos ejemplos.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

CONCIENCIA ARTIFICIAL. IA, MIENTEME…QUE ME GUSTA

El informe analiza cómo la “ilusión de conciencia” en la inteligencia artificial transforma la percepción de los usuarios, detalla mecanismos técnicos que la producen y expone sus costos emocionales y comerciales, con casos recientes y propuestas de mitigación para reducir riesgos en salud mental y en la relación humano-máquina.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!