Este informe explora las bases arquitectónicas, técnicas y sociales de la inteligencia artificial moderna, abordando sus métodos de entrenamiento, criterios de evaluación, infraestructura tecnológica y desafíos éticos en su implementación global.

Autor: Alejandro Castillo

Aprendizaje y evaluación de modelos

El aprendizaje de los modelos de inteligencia artificial (IA) no se limita a procesar datos, sino que se enfoca en extraer estructuras útiles que permitan operar en entornos complejos con precisión y eficiencia. Las técnicas de aprendizaje auto-supervisado han permitido avances clave al eliminar la dependencia de datos etiquetados, mientras que los métodos contrastivos mejoran la representación semántica al distinguir relaciones internas entre datos diversos.

El preentrenamiento masivo prepara a los modelos con patrones generales, mientras que el aprendizaje en línea permite adaptarse en tiempo real a nuevas condiciones. La vida útil de un modelo se divide en entrenamiento, inferencia y ajuste fino, siendo este último esencial para adaptar modelos generales a tareas concretas.

La evaluación del rendimiento supera la mera exactitud: se analiza la coherencia, la veracidad y la fluidez, empleando métricas como BLEU, ROUGE o METEOR, complementadas con validaciones humanas.

La capacidad para generalizar sin sobreajuste se verifica mediante la correcta partición de datos en conjuntos de entrenamiento, validación y prueba. Además, se estudian mecanismos de evaluación factual y detección de sesgos como parte integral de los estándares de calidad actuales.

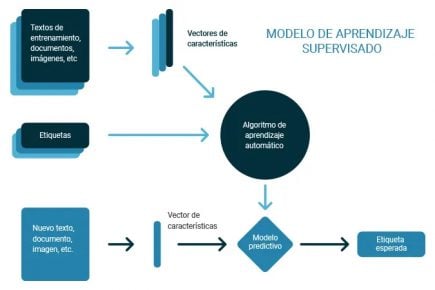

En el aprendizaje supervisado, los modelos se entrenan con datos previamente etiquetados, ajustando sus predicciones a partir de los errores entre la salida esperada y la estimada.

Arquitecturas, memoria y escalabilidad

El rendimiento de los modelos actuales se apoya en su capacidad para mantener contexto, distribuir la atención y optimizar el procesamiento a través de arquitecturas avanzadas. La expansión de las ventanas de contexto ha permitido trabajar con secuencias extensas, facilitando razonamientos complejos sin segmentación artificial.

Modelos como GPT-4 Turbo o Claude 3 han incrementado el límite a más de 100.000 tokens gracias a técnicas como la atención dispersa y memoria externa. Esta última permite que los modelos recuerden interacciones anteriores, incluso fuera del contexto inmediato, a través de bases vectoriales o resúmenes embebidos.

También se incorporan arquitecturas modulares, como Mixture of Experts (MoE), que seleccionan dinámicamente submodelos especializados, logrando eficiencia sin perder capacidad.

Los enfoques híbridos simbólico-conectivistas integran reglas lógicas con aprendizaje estadístico, mientras que los modelos modulares permiten actualizar componentes sin reentrenar el sistema completo, favoreciendo la trazabilidad y la adaptación a contextos específicos.

Las NPUs (Neural Processing Units), integradas en chips como los de Apple o Qualcomm, permiten ejecutar modelos de inferencia directamente en teléfonos inteligentes, relojes o vehículos, reduciendo la dependencia de la nube y mejorando la privacidad.

Infraestructura, sostenibilidad y agentes autónomos

La evolución de la IA está profundamente ligada al desarrollo de hardware especializado y a la infraestructura que lo respalda. Chips como los H100 de NVIDIA y los WSE de Cerebras han redefinido los límites del rendimiento, aunque con altos costos energéticos.

Para reducir el impacto ambiental, se promueven centros de datos alimentados por energía renovable, enfriamiento líquido y algoritmos energéticamente eficientes. Además, el uso de TPUs, FPGAs, NPUs y ASICs ha expandido la IA a dispositivos personales y sistemas industriales con menor consumo.

El entrenamiento de modelos a gran escala enfrenta desafíos técnicos, logísticos y éticos debido a su consumo eléctrico equivalente al de ciudades enteras. Paralelamente, la aparición de agentes autónomos marca un nuevo capítulo: estos sistemas perciben, planifican y actúan sin intervención humana directa, aplicándose en robótica, automatización de tareas, comercio electrónico y servicios.

La transición de agentes reactivos a proactivos ha mejorado la autonomía operativa, aunque plantea nuevos retos en seguridad, control y regulación. Robots humanoides, por ejemplo, comienzan a integrarse en logística y atención al público, con capacidades de adaptación y aprendizaje continuo gracias a los avances en percepción y razonamiento.

En atención al público, los robots humanoides pueden ofrecer asistencia básica, orientación o acompañamiento en hospitales, aeropuertos y comercios. Aunque su capacidad técnica aún no iguala la de los humanos, su presencia física y apariencia familiar

Desafíos éticos, regulación y futuro de la IA

El crecimiento acelerado de la IA requiere marcos normativos claros y estrategias éticas robustas. Regulaciones como el AI Act de la Unión Europea buscan clasificar los sistemas según su nivel de riesgo, mientras que iniciativas de la OCDE, UNESCO y el Consejo de Europa promueven principios de transparencia y respeto a los derechos humanos.

Los riesgos detectados incluyen la generación de contenido falso, el uso malicioso de modelos abiertos y la opacidad en decisiones automatizadas. Investigadores plantean escenarios de uso indebido como campañas de desinformación, ingeniería social o armas autónomas, lo que exige mecanismos de explicabilidad y mitigación de sesgos.

Para garantizar la responsabilidad algorítmica, se desarrollan herramientas como SHAP, LIME y tarjetas de modelo, junto con auditorías sistemáticas y marcos de gobernanza organizacional. Las APIs han facilitado la integración de IA en aplicaciones reales sin necesidad de infraestructura propia, pero también introducen desafíos en privacidad, dependencia externa y cumplimiento normativo.

Finalmente, aunque la inteligencia artificial general (AGI) aún no se ha alcanzado, se esperan avances en razonamiento compuesto y autonomía progresiva. Sin embargo, persisten limitaciones estructurales en extrapolación entre dominios, robustez ante ambigüedad y comprensión contextual, lo que mantiene abierta la discusión sobre el futuro de la inteligencia artificial verdaderamente autónoma.

En defensa, sistemas como Anduril y Palantir combinan sensores, visión computacional y análisis multifuente para generar mapas de riesgo, vigilar fronteras y coordinar operaciones complejas. Estas soluciones se usan en escenarios reales donde la rapidez y la precisión superan la capacidad humana para procesar información simultánea.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

BASES DE LA IA

La inteligencia artificial (IA) ha pasado de ser un concepto teórico a una tecnología omnipresente que transforma nuestra vida cotidiana. Desde asistentes virtuales hasta sistemas avanzados de automatización, su impacto es innegable.

Comprender sus bases es esencial para aprovechar su potencial y anticipar su evolución futura. Este resumen explora los fundamentos de la IA, su evolución histórica, sus aplicaciones actuales y los desafíos que plantea en términos de regulación y ética.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!