Guía paso a paso para pasar de un notebook local a sistemas de machine learning productivos en Google Cloud, usando Vertex AI, BigQuery y Cloud Storage, con ejemplos de AutoML, entrenamiento personalizado, despliegue a endpoints y prácticas de MLOps para mantener modelos en producción.

Autor: Claudio Peña

Preparación del entorno en Google Cloud

El documento propone crear un proyecto en la consola de Google Cloud, activar la facturación con un presupuesto para alertas y habilitar APIs clave como Vertex AI, BigQuery y Cloud Storage.

Plantea tres puertas de entrada al desarrollo: Cloud Shell con el SDK (gcloud, bq, gsutil), el SDK local con autenticación por línea de comandos y Vertex AI Workbench como notebooks gestionados con bibliotecas precargadas e integración directa a datos.

Recomienda fijar una estructura mínima: un bucket en Cloud Storage para datasets y artefactos de entrenamiento, un dataset en BigQuery para datos tabulares y un notebook en Workbench para análisis exploratorio.

Subraya que la nube resuelve la brecha entre prototipos y sistemas escalables: versionado de datos y modelos, reentrenos automáticos, baja latencia en inferencia y permisos cruzados vía IAM para que Vertex AI pueda leer de BigQuery y Storage.

La guía insiste en elegir regiones coherentes entre servicios y en crear buckets con nombres únicos, verificando cuotas y accesos antes de entrenar para evitar errores comunes.

El verdadero trabajo del Machine Learning Engineer actual abarca construir el ciclo de vida completo involucrado: procesar enormes cantidades de datos en tiempo real, gestionar el versionado de los datos y modelos, reentrenar automáticamente cuando el rendimiento cae y desplegar un modelo como un servicio online con baja latencia…por nombrar lo más importante.

Datos, notebooks y entrenamiento en Vertex AI

La ruta de datos comienza cargando tablas en BigQuery desde CSV, transferencias o consola, y consultándolas con SQL o desde pandas en Workbench. Se promueven buenas prácticas: limpieza, creación de variables y persistencia del dataset procesado en Storage o BigQuery para trazabilidad.

Con el proyecto listo, Vertex AI ofrece dos caminos de entrenamiento. AutoML Tabular permite construir modelos de clasificación, regresión y forecasting sin código, optimizando hiperparámetros y entregando métricas, matriz de confusión y un modelo registrable y desplegable.

Para control total, el entrenamiento personalizado en Workbench usa frameworks como TensorFlow o PyTorch, con envío del job a Vertex AI mediante SDK y elección de recursos como CPU, GPU o TPU.

BigQuery ML aparece como alternativa para crear modelos directamente con SQL sin mover datos, acelerando ciclos cuando el equipo domina el ecosistema de BigQuery.

El texto aporta ejemplos de código: consultas a BigQuery, creación de columnas derivadas, carga de datasets a Vertex AI y ejecución de AutoML con budget mínimo (milli node hours) y objetivo de optimización, aclarando que el run es sincrónico y que el estado también se puede seguir desde la consola.

El ecosistema de Vertex se compone de varios elementos. Workbench, BigQuery y los procesos de creación y publicación de modelos son los pilares para completar todos los procesos de ML.

Despliegue, monitoreo y MLOps en producción

Una vez validado el modelo, Vertex AI habilita su publicación como endpoint HTTPS para predicciones en tiempo real, ya sea desde la interfaz o vía SDK/gcloud, con control de tipo de máquina y distribución de tráfico.

El consumo se ilustra con un ejemplo de inferencia que envía una instancia JSON y recibe probabilidades. Para sostener calidad en el tiempo, el material introduce prácticas de MLOps: registro de versiones en el Model Registry, monitoreo de deriva y rendimiento, análisis de sesgo y explicabilidad, y orquestación de flujos repetibles con Vertex AI Pipelines para reentrenos y validaciones continuas.

Además, destaca el Model Garden de Vertex AI con más de 200 modelos preentrenados, incluidos grandes modelos de lenguaje y visión de Google y terceros, que se pueden probar, adaptar y desplegar rápidamente, así como AI Studio para experimentar con modelos generativos en tareas de texto, código, imágenes y audio.

En conjunto, el itinerario describe cómo configurar cuentas y permisos, organizar datos, entrenar con AutoML o código propio, publicar servicios de inferencia y establecer el ciclo de vida operativo, logrando que proyectos de ML escalen con seguridad y rendimiento en Google Cloud.

Vertex AI incluye herramientas de MLOps (Machine Learning Operations) que automatizan las tareas de actualización, evaluación continua y monitoreo. Podemos registrar versiones de modelos en el Registro de modelos de Vertex AI, realizar análisis de sesgo o explicabilidad, y monitorear la deriva de datos en producción con el Monitoreo de Modelos.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

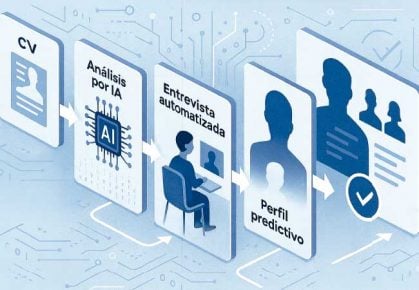

BUSQUEDA DE TRABAJO CON IA

El informe analiza cómo la inteligencia artificial redibuja la búsqueda laboral: desde la caída de empleos de entrada hasta entrevistas automatizadas, filtros invisibles y nuevas exigencias de habilidades. Expone impactos en Latinoamérica, riesgos de homogeneización y claves prácticas para diferenciar perfiles en entornos digitales.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!

cUxRaNFukQNVbllwHnfnEP