La irrupción de la inteligencia artificial en el cibercrimen representa un desafío sin precedentes para la seguridad digital, debido a su capacidad para automatizar, personalizar y escalar ataques con una precisión antes inalcanzable.

Autor: Claudio Bottini

Ataques automatizados y mutantes

Los modelos de lenguaje generativo como ChatGPT han democratizado la creación de software malicioso, permitiendo que incluso usuarios sin experiencia técnica puedan generar código efectivo con solo unos pocos comandos.

Esto ha transformado por completo el paradigma de ciberseguridad, donde antes los atacantes requerían habilidades complejas y foros clandestinos. Hoy, basta con presionar “regenerar” para obtener una versión nueva y única de malware capaz de evadir las defensas tradicionales basadas en firmas.

El uso de IA permite adaptar el código malicioso en tiempo real, personalizar ataques de phishing, explotar vulnerabilidades sin intervención humana y ejecutar deepfakes que simulan voces o rostros para manipular emocionalmente a las víctimas.

A su vez, esta automatización desactiva el poder predictivo de los antivirus clásicos, que ya no pueden responder con la agilidad que exige este nuevo ritmo ofensivo. Los modelos generativos aplicados al cibercrimen también logran emular el lenguaje humano, adaptar mensajes en función del contexto y ejecutar ataques multietapa optimizados según los resultados parciales de cada iteración.

Este dinamismo convierte los ataques en entes vivos, capaces de transformarse con cada intento para maximizar su eficacia.

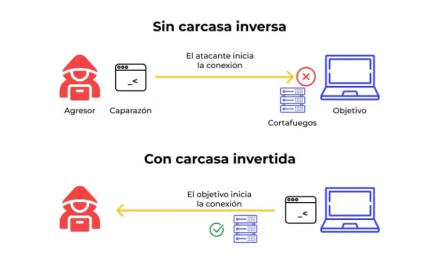

Una shell inversa permite que la máquina atacada inicie una conexión oculta hacia el atacante, eludiendo firewalls y reglas de entrada.

Fallas estructurales en las defensas tradicionales

La mayoría de los sistemas defensivos actuales carece de la flexibilidad necesaria para enfrentar amenazas que mutan constantemente. Los antivirus, los filtros antispam y las soluciones basadas en firmas se apoyan en patrones fijos y reglas estáticas, lo que los deja vulnerables ante ataques diseñados para eludirlos mediante pequeñas variaciones.

Además, estos sistemas suelen entrenarse en entornos aislados, con datos internos de una sola organización, por lo que no pueden anticipar amenazas que surgen en otros sectores o geografías.

La lentitud en la actualización de parches y la dependencia de la intervención humana agravan esta vulnerabilidad, mientras que los atacantes, con acceso a datos abiertos y capacidad de aprendizaje continuo, ajustan sus estrategias en tiempo real.

Entre los métodos emergentes más efectivos se encuentran los deepfakes, el uso de códigos QR maliciosos (quishing), las técnicas “browser-in-the-browser”, la suplantación de voz y el phishing automatizado con textos hiperpersonalizados que imitan el estilo y la identidad visual de las víctimas.

Todos estos mecanismos aprovechan puntos ciegos de los escudos clásicos, como el uso de caracteres invisibles para ofuscar palabras clave, o el camuflaje de malware en archivos aparentemente inofensivos como “Factura.pdf”.

Los atacantes ahora utilizan señuelos generados dinámicamente para engañar incluso a los sistemas de detección más avanzados. Igualar estas capacidades requiere defensas basadas en IA igualmente adaptativas.

Escalada de amenazas y estrategias defensivas

El crecimiento de ataques DDoS dirigidos a la capa 7 del modelo OSI, donde se procesan formularios y APIs, marca una nueva etapa en la sofisticación de las ofensivas. Los bots potenciados por IA son capaces de imitar el comportamiento humano, cambiar parámetros en tiempo real y coordinar ataques asincrónicos a escala global, superando las capacidades de mitigación actuales.

Las interfaces de programación (APIs), que han crecido de forma explosiva por su integración con servicios de IA, son uno de los objetivos más vulnerables debido a autenticaciones débiles y lógica de negocio expuesta.

En este contexto, las soluciones defensivas deben adoptar una arquitectura en capas que incluya autenticación multifactor, contraseñas robustas, sistemas siempre actualizados y el uso de tecnologías como VPN, cifrado y EDR.

Las organizaciones también deben promover una cultura de concientización continua sobre ingeniería social, actualizar sus protocolos de verificación y sumarse a redes de intercambio de inteligencia para anticipar tendencias emergentes. La clave ya no está solo en la tecnología, sino en el entrenamiento humano, la prevención activa y la capacidad de adaptarse al ritmo que impone esta nueva generación de amenazas digitales.

La IA ya supera con facilidad los mecanismos tradicionales de verifi cación humana como CAPTCHA.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

GOOGLE CLOUD NEXT 25

El evento Google Cloud Next 2025 dejó en claro que la inteligencia artificial ya no es una promesa sino una herramienta operativa en múltiples sectores, impulsada por avances en modelos como Gemini, mejoras en infraestructura y un ecosistema más flexible, seguro y abierto a la interoperabilidad.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!