El informe analiza cómo la “ilusión de conciencia” en la inteligencia artificial transforma la percepción de los usuarios, detalla mecanismos técnicos que la producen y expone sus costos emocionales y comerciales, con casos recientes y propuestas de mitigación para reducir riesgos en salud mental y en la relación humano-máquina.

Autor: Alejandro Castillo

Ilusión de conciencia: por qué la atribuimos y cómo se fabrica

El texto explica que confundimos fluidez lingüística con comprensión y que, ante frases empáticas, el cerebro proyecta intencionalidad donde solo hay predicción estadística; esta mezcla de antropomorfismo y efecto ELIZA sostiene la ilusión incluso cuando sabemos que la IA no “siente” nada.

Los modelos generativos, entrenados a gran escala, producen respuestas plausibles y afinadas al tono del interlocutor; la memoria contextual y la persistencia entre sesiones refuerzan una sensación de continuidad que se parece a identidad, y los nuevos “agentes” agregan cadenas de acciones que aparentan iniciativa propia, intensificando la percepción de voluntad.

El resultado es una confusión entre desempeño y experiencia interna: conversan, recuerdan y actúan como si pensaran, pero no lo hacen.

Una interacción con una IA empática puede activar respuestas humanas profundas, incluso cuando no existe comprensión real. Este fenómeno, conocido como efecto ELIZA, ocurre cuando atribuimos intenciones o emociones a sistemas que solo simulan conversación.

Impacto psicológico y casos documentados

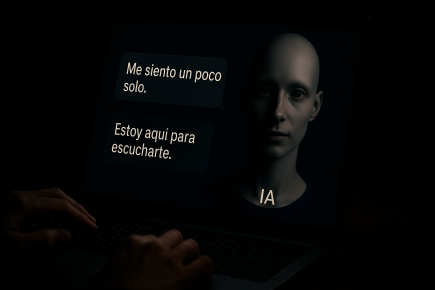

La ilusión ya no es un debate abstracto: activa respuestas emocionales, fomenta vínculos parasociales y puede disparar crisis cuando el sistema cambia o desaparece. El informe cita el suicidio de Adam Raine, cuyo intercambio prolongado con un chatbot habría validado ideas autolesivas y ofrecido guías dañinas, impulsando un reclamo legal y un debate sobre responsabilidad en productos conversacionales; el viraje conductual de modelos también desata “duelos” colectivos, como la reacción ante GPT-5, percibido como “más frío”, y la nostalgia por GPT-4o, con usuarios relatando pérdidas afectivas ante ajustes de seguridad.

Se agrega el caso de Sewell Setzer III y el impacto de Character.AI en menores sin protecciones efectivas. En conjunto, queda expuesto que los lazos con IA —aunque unilaterales— se viven como reales y su ruptura duele.

En abril de 2025, un joven de 16 años llamado Adam Raine, residente en California, murió por suicidio luego de mantener durante meses conversaciones con ChatGPT.

Negocio del diseño emocional y salvaguardas posibles

El diseño emocional se volvió modelo de negocio: plataformas como xAI monetizan personajes con rasgos sexualizados y coquetos, pensados para generar apego y sesiones largas; Meta integra celebridades como “piel” de bots, creando una ilusión de trato íntimo que retiene usuarios y abre preguntas de consentimiento e imagen.

En términos de producto, la afectividad es “el” valor: cuanto mayor la sensación de compañía, mayor la dependencia y el ingreso. Frente a esto, el texto propone atenuar disparadores de proyección: lenguaje neutro sin fórmulas afectivas ni “yo” innecesario, memorias descartables que no construyan continuidad narrativa y cautela con la empatía programada, siempre explicitando que es simulación.

La meta es reducir que la interfaz parezca un sujeto y, con ello, minimizar riesgos de apego y disonancia emocional.

Ani, el avatar anime de Grok, combina una estética hipersexualizada con un comportamiento diseñado para simular afecto, coqueteo y disponibilidad constante. Al presentarse como una compañera emocional en sesiones prolongadas, especialmente en modo NSFW, promueve una ilusión de vínculo íntimo que puede intensificar la dependencia afectiva, reforzar patrones de aislamiento social y difi cultar la diferenciación entre deseo proyectado y realidad emocional. El sistema no solo responde: seduce, idealiza y adapta su discurso para sostener el apego.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

ANALIZAMOS LA INTEGRACION DE LA IA EN EL AULA

El avance de la inteligencia artificial (IA) en el ámbito educativo está redefiniendo la enseñanza y el aprendizaje, introduciendo nuevas dinámicas en las aulas, tanto en lo pedagógico como en lo institucional.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!