La llegada de El Eternauta a Netflix representa un hito para la producción audiovisual argentina, no solo por adaptar una obra emblemática del cómic nacional, sino por su despliegue técnico, que la sitúa a la altura de grandes producciones internacionales.

Autor: Claudio Peña

Tecnología de vanguardia desde la preproducción

Desde su etapa inicial, El Eternauta se apoyó en un proceso de preproducción digital exhaustivo que incluyó modelado 3D, guiones técnicos en Final Draft y escaneo urbano de alta precisión.

Se recreó una versión digital de Buenos Aires, navegable en tiempo real como un entorno de videojuego, lo que permitió al equipo anticipar ángulos de cámara y climas visuales. Los animatics animados sirvieron para coordinar con precisión los movimientos de cámara, actuaciones y efectos, mientras que la producción virtual con pantallas LED eliminó la necesidad de chroma key y permitió proyectar paisajes en tiempo real.

Este sistema, basado en Unreal Engine, incorporó tecnologías como Lumen y Nanite, fundamentales para lograr iluminación dinámica y geometría compleja sin sacrificar fluidez operativa.

Durante el rodaje, sensores y cámaras virtuales sincronizadas permitieron simular movimientos en entornos tridimensionales, fusionando escenarios reales y digitales con coherencia visual. El uso de iluminación reactiva, capaz de integrarse con el contenido proyectado, elevó la calidad de captura desde el set, reduciendo la carga de postproducción.

La preproducción digital sentó las bases para la producción virtual posterior y garantizó una continuidad visual sostenida a lo largo del proyecto.

Postproducción avanzada y criaturas digitales

Tras finalizar el rodaje, comenzó una etapa de refinamiento técnico que buscó integrar los elementos físicos con efectos visuales de alto nivel. En postproducción, se diseñó una Buenos Aires transformada, con atmósferas densas y señales alienígenas, utilizando ShotGrid para coordinar el trabajo entre equipos globales.

La composición se realizó en Nuke, mientras que las simulaciones atmosféricas, como la nevada tóxica, se programaron en Houdini con parámetros físicos detallados. Las criaturas no humanas fueron creadas en ZBrush, animadas en Maya y adaptadas con motion retargeting para conservar realismo y peso.

La corrección de color se aplicó para mantener unidad visual entre interiores e imágenes generadas por computadora, con una paleta de grises y ocres que reforzaba la tensión narrativa. En paralelo, el diseño sonoro en Dolby Atmos aportó espacialidad sin sobresaturación, y las granjas de render con GPUs NVIDIA RTX procesaron efectos en alta fidelidad con ray tracing y sombreado volumétrico.

Todo el pipeline fue ajustado para acelerar decisiones sin comprometer el resultado estético.

El sistema incluyó más de 120 m² de pantallas LED de alta defi nición sincronizadas con los contenidos generados digitalmente, lo que hizo posible que la luz, el color y la atmósfera se integraran directamente en la escena grabada, sin necesidad de reconstrucciones posteriores.

Inteligencia artificial y estreno internacional en streaming

La inteligencia artificial tuvo un rol clave como soporte técnico y operativo. En postproducción, automatizó la rotoscopía y mejoró imágenes mediante limpieza inteligente, sin desplazar el control creativo.

Se utilizó además para corregir audios, predecir cuellos de botella en los flujos de render y generar prototipos visuales a partir de prompts. El estreno mundial, gestionado por Netflix, exigió una infraestructura de distribución escalable, con versiones en AV1 y masterización en Dolby Vision, que adaptó brillo y color a cada dispositivo.

La automatización de versiones localizadas —con subtítulos, doblajes y descripciones— garantizó accesibilidad y coherencia visual a nivel global. La experiencia técnica fue monitoreada mediante sistemas como Photon, asegurando la entrega sin fallos.

Esta producción demostró que, con planificación y recursos adecuados, la industria audiovisual argentina puede crear ciencia ficción de exportación, integrando herramientas de última generación con talento local. Aunque persisten desafíos —como la dependencia de servicios externos o los debates sobre IA—, El Eternauta deja un precedente que amplía el alcance de lo que el sector puede imaginar y construir.

En algunas tomas se incorporaron sensores sobre actores u objetos, logrando que ciertos elementos del escenario reaccionaran dinámicamente a su presencia.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

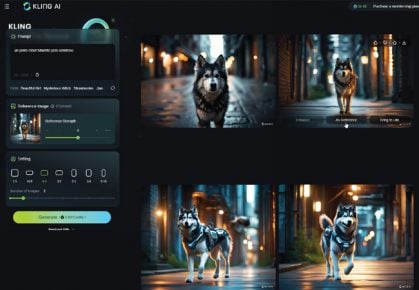

KLING GENERA VIDEOS CON IA

Kling es un modelo de inteligencia artificial desarrollado por Kuaishou, que tiene la capacidad de generar videos a partir de descripciones textuales. Esta herramienta permite a los usuarios crear videos basados en guiones o indicaciones escritas, lo que la convierte en una herramienta poderosa y versátil en el ámbito de la creación de contenido visual.

Kling se destaca por su capacidad de generar animaciones y efectos visuales con un alto grado de creatividad artística, y esto lo hace ideal para una amplia variedad de proyectos que requieren un toque visual único.

Además, cuenta con una arquitectura de atención 3D que le permite modelar movimientos complejos, logrando que los objetos dentro del video interactúen de una manera realista y convincente.

Los videos creados por Kling pueden alcanzar una resolución de 1080p, lo que garantiza que se mantenga una calidad visual elevada en todos los proyectos que se generan con esta herramienta.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!