Este informe de USERS presenta un mapa actual de la inteligencia artificial generativa multimedia, sus capacidades técnicas, casos de uso y límites, comparando modelos para imagen, audio, video y 3D, y revisando control creativo, integración profesional, licencias, ética y tendencias.

Autor: Elisa Belmar

De la imagen al ecosistema multimedia

La IA generativa pasó de experimentos aislados a un sistema transversal que produce imágenes, video, audio, voces y objetos 3D desde lenguaje natural.

El prompt opera como interfaz universal: una misma consigna puede derivar en ilustraciones, clips con movimiento y sonido o entornos inmersivos. Tras el despegue con DALL·E, Imagen y Stable Diffusion en 2021, la evolución se expandió hacia medios temporales y espaciales, resolviendo continuidad en video y naturalidad vocal.

Entre 2023 y 2025 se consolidaron hitos:

- Sora incorporó simulación física y coherencia temporal

- Midjourney y MAI Image elevaron la calidad visual para diseño

- ElevenLabs y PlayHT pulieron voces multilingües con matices emocionales

- Sunō AI produjo canciones completas

- Hunyuan3D y Luma AI habilitaron generación y reconstrucción 3D exportable.

La tendencia es clara: sistemas modulares que comparten el lenguaje como punto de partida, capaces de mantener un universo narrativo consistente entre modalidades y de integrarse gradualmente en flujos profesionales.

Aunque los modelos actuales todavía funcionan de manera especializada —es decir, un modelo genera imágenes, otro videos, otro voz—, se observa una tendencia creciente hacia la integración de medios. Algunos sistemas ya permiten combinar generación de imagen con movimiento, voz con animación facial, o sonido con visualización espacial. Esta convergencia técnica no implica que todo modelo sea multimodal, sino que el usuario puede, desde un mismo punto de partida textual, obtener distintos tipos de contenido compatibles entre sí.

Capacidades por medio: audio, imagen, video y 3D

En audio, los motores TTS y musicales ya resuelven narración y ambientación.

- ElevenLabs destaca por naturalidad y control emocional

- PlayHT por clonación vocal autorizada y baja latencia

- Voicemod por personalización en tiempo real

- Sunō AI por canciones estructuradas

- MusicGen de Meta por composición instrumental abierta

- Stability Audio por texturas y efectos.

El desempeño se define por tono, emoción y latencia, con usos que van desde doblaje multilingüe con lipsync automático hasta fondos sonoros para cine y juegos.

En imagen,

- Midjourney V7 ofrece estética pictórica y consistencia estilística

- DALL·E 3 brilla por comprensión semántica del prompt y resultados editoriales limpios

- Imagen 3 privilegia coherencia naturalista, texturas e iluminación estables, con integración en el ecosistema de Google.

En video,

- Sora produce hasta 60 segundos en 1080p con continuidad de objetos, cámaras y atmósferas

- Runway Gen-4 acerca el proceso a creadores con herramientas interactivas y clips de 16 segundos

- Veo 3.1 exhibe control cinematográfico, profundidad de campo y transiciones fluidas.

En 3D,

- Hunyuan3D logra mallas con buen detalle estructural

- GET3D genera variaciones eficientes para simulación y videojuegos

- Luma AI reconstruye escenas mediante NeRFs con exportación GLTF y USDZ

- Tripo facilita la creación desde texto para prototipado y educación.

La compatibilidad con OBJ, FBX, GLTF o USDZ reduce fricción para llevar activos a Unity, Unreal, Blender o pipelines XR.

La ventaja distintiva de DALL·E radica en la precisión con que interpreta conceptos abstractos, metáforas visuales o situaciones narrativas, logrando resultados de composición limpia y con menor intervención de ajustes técnicos.

Control, integración y marcos éticos

El control comienza en el prompt y se amplía con interfaces y APIs. En imagen y video puede fijarse estilo, composición, plano y movimientos de cámara; en audio se ajustan tono, ritmo, acento y prosodia. Runway añade pinceles de movimiento y edición cuadro a cuadro.

Los modelos 3D permiten modificar geometría, UV y materiales, y luego refinar en software profesional. Persisten límites: la precisión depende del entrenamiento, el control fino intra-secuencia es parcial y la sincronía perfecta entre modalidades aún es una frontera activa.

La integración técnica avanza con APIs y SDKs:

- ElevenLabs expone REST y tiempo real

- PlayHT facilita lotes y autenticación por token

- MusicGen, al ser abierto, se integra localmente

Esto habilita pipelines escalables en nube o servidores propios, con exportaciones listas para DAWs, editores de video y motores de tiempo real.

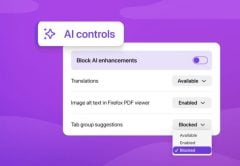

El capítulo ético aborda clonación de voz, derechos de autor y deepfakes. La clonación sin consentimiento expone a fraudes y usurpación de identidad. El entrenamiento con obras protegidas genera litigios y acuerdos de compensación o exclusión voluntaria. Los deepfakes impulsan etiquetas de procedencia y detección, aunque la eficacia técnica es desigual.

En 2025, el AI Act de la Unión Europea clasifica riesgos y exige transparencia, en Estados Unidos la FTC y estados regulan anuncios con IA y derechos post mortem, en Asia se pide registrar modelos y detallar fuentes y supervisión humana, UNESCO y OCDE promueven principios de uso responsable.

El panorama futuro se orienta a multimodalidad en tiempo real, avatares conversacionales con memoria y mundos generativos navegables, con la IA como coautora narrativa que colabora en continuidad de estilo, construcción de escenas y escalabilidad de historias en educación, marketing, videojuegos y comunicación institucional.

En herramientas con storyboards integrados —como Pika o funciones avanzadas de Veo— el usuario puede definir secuencias de eventos o estructuras narrativas divididas en actos. Aunque estas funciones están en desarrollo, ya es posible indicar transiciones entre escenas, énfasis narrativos o incluso sugerir plot twists (giros argumentales), aunque con resultados más variables que en el caso de la generación estática.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

IA EN EL CINE HOLLYWOOD YA ES ARTIFICIAL

La IA dejó de ser promesa y ya moldea guiones, rodajes y pantallas. El informe recorre usos creativos y técnicos, herramientas clave, tensiones laborales y legales, y el panorama argentino y latinoamericano.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!