Un grupo de cinco estudiantes de Ingeniería de la Universidad de La Matanza (UNLaM) creó Onis, un software para Windows que utiliza la cámara de Kinect y traduce en pantalla el lenguaje de señas argentino (LSA). De esta manera, permite establecer una comunicación entre personas sordas con sus allegados que no sepan el lenguaje.

“Comenzamos a tirar ideas y, dentro de las sugerencias, los profesores seleccionaron esta idea. El objetivo es que una persona oyente no requiera saber el lenguaje de señas para comunicarse con una persona sorda, quien a su vez pueda comunicarse con señas. También sirve para aprender la lengua de señas”, indicaron a RedUSERS los integrantes del equipo, conformado por: Christian Bermúdez, Érika Garrido, Marcelo Canella, Natalia Lara y Nelson Juárez.

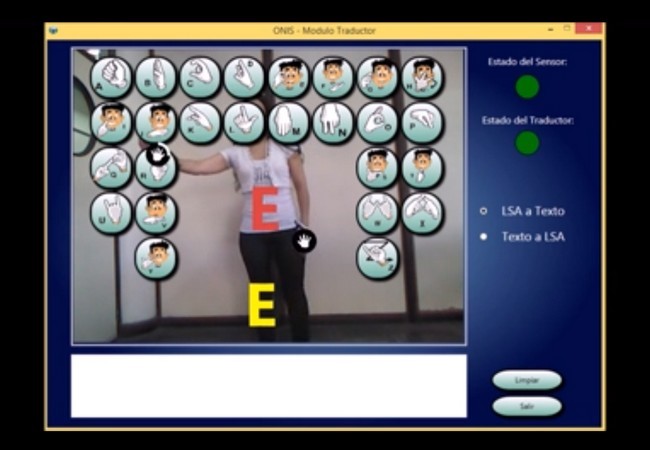

El producto tiene dos funciones. La primera es un traductor, donde el usuario realiza una seña y del otro lado llega texto, mientras que en el segundo modo alguien escribe y representan en el monitor las señas mediante imágenes. Una tercera funcionalidad es el módulo de chat.

“Estamos trabajando con las escuelas de enseñanza especial 513 y 517, con quienes vamos probando el programa, la interfaz y cómo se realizan las señas. Nos estamos asesorando con ellos. También nos ayudó el Centro Dar, que nos ofreció todos los contactos para arrancar con el proyecto”, añadieron los chicos.

Allí descubrieron que las personas sordas se sienten muy integradas en la escuela, pero no fuera de ella. Incluso hallaron el caso de un chico sordo de 20 años y que la familia no sabía cómo hablarle. “La peor discriminación que sufren es en el hogar”, aseguraron los chicos, que terminaron Onis en seis meses dentro de la materia Proyecto, con la que se reciben los alumnos de Ingeniería de la UNLaM.

A la hora de mencionar el mayor desafío, los estudiantes coincidieron en las limitaciones deKinect. “Kinect no detecta los dedos, sino que detecta un sólo punto que es la mano y en base a eso tuvimos que detectar los dedos para saber qué letra se está queriendo decir“, explicaron.

Según comentaron, Kinect sólo detecta 10 puntos del cuerpo de la cintura para arriba. Por ello, pusieron en práctica conocimientos de matemática discreta, como distancia entre puntos y ángulos. Y programaron el software con Visual Studio 2010 en C#.

Lo destacable del producto es que funciona en computadoras cuyo único requisito sea que puedan correr Windows 7 y 8. De hecho, utilizaron como banco de pruebas una desktop con procesador Celerom de 1,8 GHz y 1 GB de memoria, una configuración fácilmente superable por la mayoría de las notebooks que se consiguen en el mercado actual.

“Dejamos un montón de cosas de lado para poder desarrollarlo y nos gustaría que Onis esté disponible para todas las personas que lo necesiten. No sólo para ellos, sino también para sus familiares, amigos. Suelen estar aislados y tener pocas chances laborales, porque no se pueden comunicar, y esto podría ayudarlos”, destacaron los creadores de Onis.

Además, remarcaron que les gustaría seguir con el proyecto, porque es “algo que ayuda”, pero cómo sólo se trata de un proyecto universitario necesitarían algún tipo de apoyo para continuarlo y, por ejemplo, trabajar en una versión mobile.

El proyecto puede verse funcionando en ExpoProyecto, la feria de proyectos que estará hasta el 31 de octubre en la Universidad de La Matanza. Y también pueden verla en acción en el siguiente video: