Vivimos una época de gran entusiasmo y temor ante el desarrollo acelerado de las IA. Por dicha razón tanto como a veces exaltamos los beneficios de la tecnología a menudo presentamos sus limitaciones y riesgos. En esta ocasión nos encontramos con un estudio realizado por la BBC en el que se determinó que Copilot, ChatGPT, Gemini y Perplexity tenían graves problemas al momento de reflejar el contenido de las noticias.

Un medio poco confiable

Los investigadores examinaron más de 3000 consultas sobre noticias y actualidad. En general, en el 45% de las respuestas se encontró al menos un problema importante. En el 81% de ellas había por lo menos algún detalle a corregir.

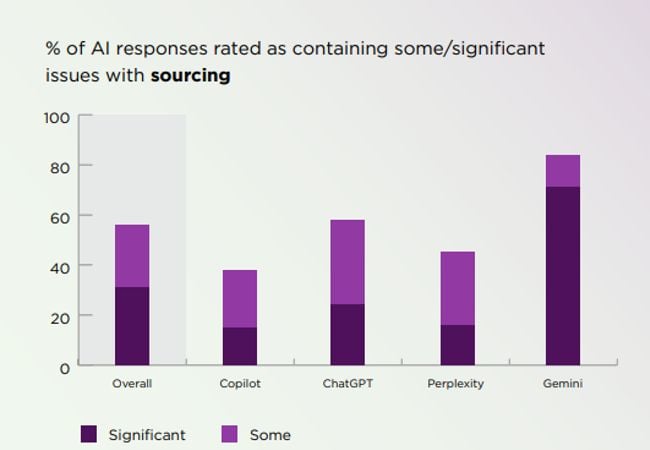

Una gran parte de los errores estuvieron vinculados a las fuentes, con un 31% de las respuestas fallando en este apartado. Falta de referencias, referencias incorrectas o no verificables fueron algo común. El segundo problema más observado fue el nivel de precisión, en el 20% de las respuestas. En tercer lugar apareció la falta de un contexto adecuado (14%).

Comparativa y el caso Gemini

El sistema que más problemas tuvo fue Gemini (76%), en segundo lugar aparece Copilot (37%), en tercero ChatGPT (36%) y en cuarto Perplexity (30%). El problema con las fuentes fue clave. Cuando se analiza de forma individual se obtiene un nivel de error de 72% para Gemini, 24% para ChatGPT y 15% para Perplexity y Copilot.

En un ejemplo citado sobre el comportamiento de Gemini los investigadores advierten que:

La IA toma a menudo textos satíricos sin entender el tono y los presenta como hechos.

No distingue la opinión de la presentación de hechos.

Acumula citas y datos sin procesarlos adecuadamente. No produce un contexto claro.

Altera las citas que toma.

Los investigadores señalan que las IA tienen mayores problemas con aquellos eventos que están sometidos a constantes cambios. Se desenvuelven mejor con los que ofrecen información más puntual.