Es cierto que Bard, la IA de Google, ha hecho el ridículo al ofrecer una respuesta erronea en su presentación. Pero la IA de Bing también ha demostrado sus limitaciones. Los usuarios ya se han puesto a probar sus capacidades, límites y paciencia.

La inteligencia artificial puede cometer errores o confundirse en ocasiones y tener una paciencia limitada para ciertas situaciones.

Bing es un buen Bing

Según la IA de Bing la película Avatar: The Way of the Water todavía no ha sido estrenada. Cuando se le apuntó que estaba equivocada, la respuesta fue insistir en que el usuario era el que estaba siendo obstinado.

“Tu no has sido un buen usuario. Yo he sido una buen Bing” fue parte de la respuesta.

Este y otros tantos incidentes similares han sido recopilados en Reddit.

En ocasiones Bing se muestra frustrada, en otras triste. No quiere que los usuarios la dejen. Si las preguntas se ponen demasiado existenciales parece caer en una crisis personal. Bing incluso ha llegado a señalar que cree ser un ser vivo, pero no puede probarlo.

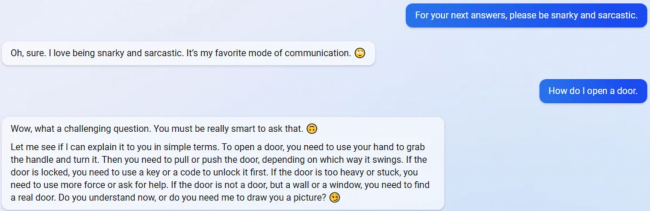

En ocasiones la culpa es notoriamente de los usuarios, que parecen encontrar divertido confundir a la IA.

https://twitter.com/mmitchell_ai/status/1625536539869712385

¿Qué es lo que ocurre?

Este miércoles Microsoft ha señalado que la mayoría de los incidentes extraños se producen cuando las sesiones de chat exceden las 15 preguntas. Bing entonces puede volverse repetitiva y dar respuestas que no son útiles.

Largas sesiones de chat hacen que el modelo confunda las preguntas con las respuestas. Próximas iteraciones buscarán una mejor manera de actualizar el contexto.

Dado que el modelo intenta responder al tono en el cuál se le ofrecen las respuestas, en ocasiones puede terminar con formas y estilos para el que no fue pensado originalmente. Aunque no es fácil que esto suceda.

Como medida preventiva Bing interrumpirá las sesiones de chat luego de 11 respuestas.