La consigna parece ser poner inteligencia artificial en cualquier tarea en la que sea posible. En muchos casos, como por ejemplo en el ámbito científico y médico, se han producido una gran cantidad de experiencias positivas. Pero en otros, como en el arte y la educación, los resultados han sido o bien mediocres o tenido consecuencias indeseadas.

Una de las áreas en las que las inteligencias artificiales prometen mucho, pero al mismo tiempo son un factor de riesgo es la de la justicia. Por un lado una IA podría acelerar increíblemente el procesamiento de las causas, aliviando a los sistemas y ofreciendo respuestas más veloces. Pero por el otro lado, las IA tienden a inventar cosas.

Menos alucinaciones, pero todavía demasiadas

Los modelos han mejorado mucho en estos últimos meses, y las empresas dedicadas al desarrollo de soluciones específicas afirman haber reducido las alucinaciones. Sin embargo, un estudio de la Universidad de Stanford realiza varios comentarios críticos al respecto.

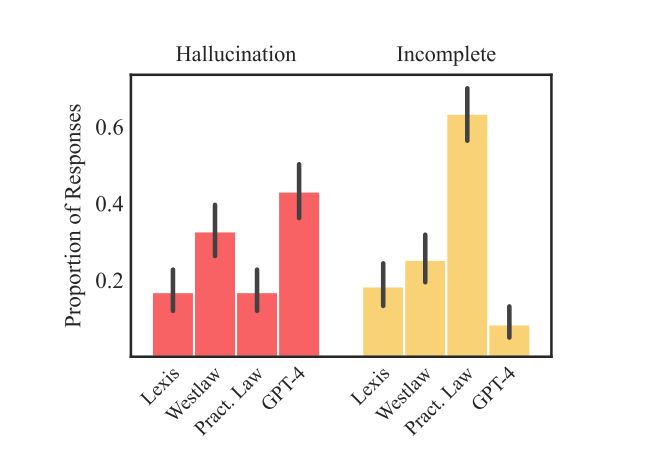

En el estudio se tomaron un total de 200 consultas legales y se observó los resultados provistos por los modelos específicos y los que ofrecía Chat GPT-4. La buena noticia es que de forma comparativa los modelos específicos producían menos alucinaciones. Sin embargo, la cantidad de ocasiones en las que desvariaban eran todavía preocupante. Lexis+, Westlaw y Ask Practical Law. Produjeron alucinaciones entre el 17 y el 33% de los casos.

También se apuntó que las herramientas tienen grandes dificultades para realizar análisis complejos.

El problema de la falta de contexto

La reducción en las alucinaciones se consiguió a través de la técnicas conocida como RAG, que básicamente supone el chequeo de las respuestas con fuentes externas, a menudo bases de datos relevantes. El problema es que en ocasiones las preguntas no tienen una única y clara respuesta, por lo cuál establecer qué conocimiento es oportuno para el RAG no es fácil. También puede ocurrir que simplemente se enfrente una novedad, y no existan datos de apoyo.

Por otro lado se apunta que la relevancia de un documento no puede medirse solo por la similitud que tiene respecto a otro documento. Y este es el criterio que utiliza el RAG. En algunos casos los documentos pueden parecer relevantes y no serlo.

Nota: Como señalan los investigadores, un tema aparte es que no existe una clara definición para alucinación.