El informe analiza el fenómeno de las alucinaciones en inteligencia artificial generativa, su origen, tipos, impacto y las estrategias técnicas y regulatorias para mitigarlas, destacando riesgos legales, sanitarios y educativos.

Autor: Elisa Belmar

Origen y naturaleza de las alucinaciones en IA

Las alucinaciones en modelos generativos, especialmente en Large Language Models (LLM), son respuestas falsas que parecen verídicas y coherentes, pero carecen de base factual. No son errores casuales, sino consecuencia de un diseño probabilístico enfocado en predecir la siguiente palabra sin verificar la verdad. Los sesgos y vacíos en los datos de entrenamiento, junto con arquitecturas que priorizan la coherencia sobre la exactitud, favorecen este fenómeno.

Los modelos “thinking” con razonamiento profundo, como GPTo3 o Claude 3 Opus, presentan un riesgo acumulado mayor por la multiplicación de pasos lógicos, mientras que los “fast models” como Claude 3 Haiku o Gemini Nano reducen errores complejos, pero limitan el análisis profundo.

La clasificación incluye alucinaciones numéricas, factuales y referenciales, con tasas promedio que van del 15-30 % en cálculos, 5-20 % en hechos inventados y hasta 50 % en citas falsas en contextos académicos.

Su detección requiere verificación activa, ya que se presentan con la misma seguridad que las respuestas correctas.

Cuando el modelo enfrenta una pregunta para la que no tiene información directa, completa el vacío agregando detalles en lugar de admitir que no sabe la respuesta. Esta tendencia surge porque los algoritmos están optimizados para ofrecer la salida más probable según el contexto, no para evaluar la verdad.

Impacto en entornos reales

El problema trasciende lo técnico cuando genera consecuencias tangibles. En el ámbito legal, casos como el de un abogado en Nueva York que presentó jurisprudencia inexistente o el fallo contra Air Canada por políticas inventadas muestran riesgos reputacionales y económicos.

En salud, las alucinaciones pueden implicar dosis médicas erróneas o diagnósticos falsos, afectando la seguridad del paciente. En ciencia y educación, distorsionan la base de conocimiento con referencias inexistentes o explicaciones inexactas, lo que compromete la calidad académica y la reproducibilidad de investigaciones.

Incluso errores anecdóticos, como la recomendación de Google AI de agregar pegamento a la pizza, dañan la percepción pública de la tecnología. En todos estos casos, el denominador común es la ausencia de verificación humana y protocolos de control en entornos críticos.

Alucinación referencial en el ámbito legal: presentación de citas judiciales falsas por parte de un abogado que confió en la salida de ChatGPT como fuente legítima.

Estrategias de mitigación y panorama regulatorio

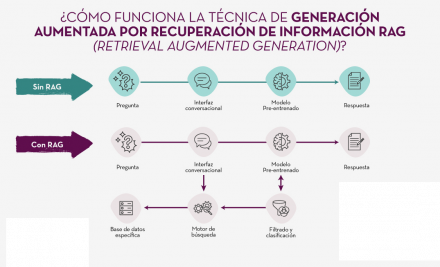

La reducción de alucinaciones combina avances técnicos y supervisión. Herramientas como Retrieval-Augmented Generation (RAG) permiten a los modelos consultar fuentes verificadas antes de responder, disminuyendo invenciones cuando faltan datos.

Sistemas verificadores y frameworks de monitoreo como CHECK o Acurai han demostrado reducciones drásticas en entornos especializados, especialmente en el ámbito médico.

A nivel regulatorio, iniciativas como la AI Act europea o los lineamientos de la OCDE proponen auditorías, trazabilidad y métricas de error obligatorias. Se impulsa el modelo híbrido human-in-the-loop, que integra control experto en cada etapa crítica.

Sin embargo, eliminar totalmente el error es imposible por la naturaleza probabilística de la IA, por lo que el reto es definir un margen de error aceptable, inferior al de un experto humano.

La industria avanza hacia estándares de calidad y transparencia, mientras que el usuario final también debe asumir un rol activo, verificando manualmente y limitando el uso de IA en decisiones sensibles, garantizando que la automatización complemente y no sustituya el juicio humano.

Comparativa del flujo de generación de respuestas con y sin la técnica RAG (Retrieval-Augmented Generation). El enfoque tradicional se limita al modelo preentrenado, mientras que RAG incorpora un motor de búsqueda y filtrado en bases de datos externas, reduciendo el riesgo de alucinaciones al reforzar la respuesta con información verificada.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

EXPLOTA TU IA AL MAXIMO

Este informe de USERS explica cómo aprovechar al máximo la inteligencia artificial generativa, presentando herramientas como ChatGPT, Gemini y Claude, y explicando técnicas de prompt, iteración, automatización y protección de datos para incorporar la IA como aliado productivo y creativo.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!