El artículo detalla paso a paso cómo desplegar un chatbot inteligente combinando N8N, Docker y el protocolo MCP, resaltando la instalación, la configuración de integraciones y la lógica que permite a la inteligencia artificial actuar de forma autónoma y escalable dentro de flujos conversacionales.

Autor: Claudio Bottini

Bases de la arquitectura

Los chatbots basados en IA se presentan como piezas claves de la transformación digital porque gestionan consultas, recomiendan productos, automatizan tareas e interactúan con servicios externos con una naturalidad inédita.

Para que un asistente resulte útil, el punto de partida es fijar su propósito: atender clientes, guiar procesos internos o disparar acciones automatizadas. Esa definición determina la estructura conversacional y los datos que empleará. También influye el perfil del usuario final, ya que un estudiante no interactúa igual que un empleado.

Una planificación descuidada puede generar dependencias difíciles de corregir en plataformas visuales; por eso conviene anticipar qué APIs, bases de datos y sistemas de autenticación se integrarán y someter el flujo a pruebas controladas antes de ponerlo en producción.

En este contexto, N8N destaca porque combina una interfaz drag-and-drop con la posibilidad de añadir código JavaScript donde resulte necesario, lo que minimiza la curva de aprendizaje sin sacrificar potencia.

Su biblioteca de más de 350 conectores nativos —desde Gmail hasta Airtable— permite que el bot reaccione en tiempo real a datos cambiantes y ejecute órdenes fiables, mientras Docker garantiza un entorno reproducible que elimina conflictos de dependencias entre Windows, Linux y macOS.

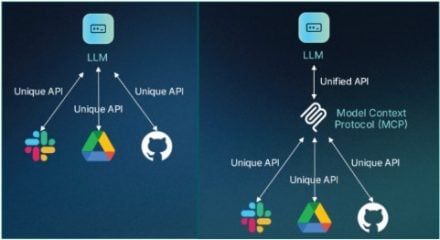

El protocolo MCP permite que modelos de IA accedan a herramientas y funciones externas desde una estructura estandarizada.

Implementación práctica con Docker y N8N

Para levantar el entorno basta instalar Docker Desktop y descargar la imagen oficial N8N, configurando un contenedor que exponga el puerto 5678, monte un volumen local para flujos y habilite la variable N8N_COMMUNITY_NODES_AS_TOOLS=true. Al iniciar sesión en http://localhost:5678 se crea la cuenta de administrador y se accede al lienzo donde se diseñará el flujo.

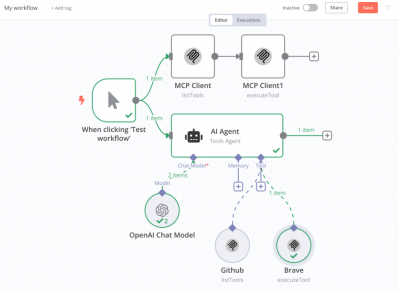

El primer nodo es un desencadenador de chat que recibe la entrada del usuario. Luego se agrega un Agente de IA enlazado a un modelo GPT-4o-mini de OpenAI; las credenciales se almacenan en n8n para su reutilización.

Un nodo de Memoria Simple preserva el contexto y permite respuestas coherentes a lo largo de la conversación. Para dotar al asistente de capacidad de búsqueda se incorpora la herramienta SerpAPI; se ingresan las claves obtenidas en el sitio oficial y se fija el idioma español.

El flujo resultante procesa cada mensaje así: el disparador almacena el texto en memoria, el Agente consulta si necesita información externa, SerpAPI devuelve resultados y el modelo redacta la respuesta final, todo visible en tiempo real en el tablero de N8N. Esta lógica puede publicarse como un chat web moviendo un deslizador en el nodo inicial y habilitando la ejecución continua, de modo que el bot quede accesible desde una URL sin escribir código adicional.

Esquema general del entorno: instalación local de n8n mediante Docker, confi guración de MCP y creación de un flujo de automatización con IA.

MCP y la selección dinámica de herramientas

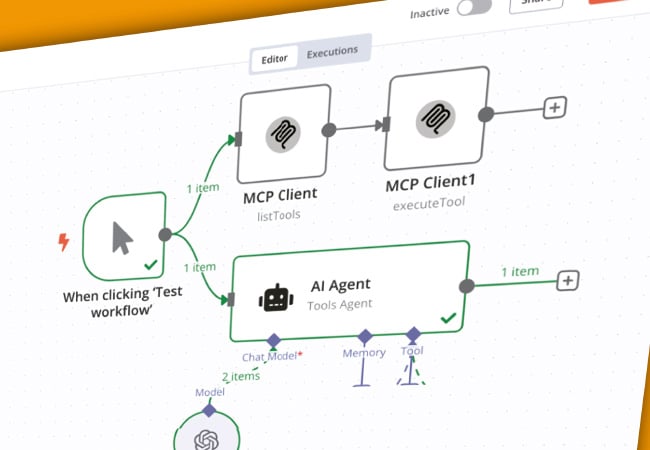

El Model Context Protocol eleva el nivel al permitir que los LLM accedan a funciones descritas de manera estandarizada. Instalar n8n-nodes-mcp en la sección de nodos de la comunidad habilita nuevos bloques: un Cliente MCP lista las herramientas disponibles en un servidor y otro las ejecuta.

En el ejemplo se conecta al servidor Brave Search mediante npx, pasando la clave BRAVE_API_KEY obtenida de Brave Search API. El Agente de IA, con la opción de selección dinámica activada, consulta la lista y decide en tiempo real qué herramienta emplear según la pregunta: un motor de búsqueda para artículos académicos, una API meteorológica para el clima en Bariloche o una base interna para stock de productos.

Este comportamiento hace que el chatbot opere como un agente verdaderamente autónomo, capaz de encadenar decisiones y acciones sin intervención humana. Cada nueva función puede agregarse como otra herramienta MCP sin rediseñar el flujo central, lo que facilita la escala y la adaptación a necesidades cambiantes.

Con N8N, Docker y MCP trabajando juntos, cualquier equipo puede disponer de un asistente conversacional robusto, entrenado para consultar fuentes confiables, ejecutar comandos y responder con rapidez, todo dentro de una arquitectura portátil y lista para producción.

Con la selección dinámica activada, el agente de IA elige la mejor herramienta de forma contextual, garantizando flexibilidad y escalabilidad.

Encuentra la versión completa de la publicación en la que se basa este resumen, con todos los detalles técnicos en RedUSERS PREMIUM

También te puede interesar:

GOOGLE I/O 2025 A FONDO

Google presentó en su evento anual un profundo cambio en su estrategia tecnológica. Bajo el lema de una innovación constante, se dejó atrás la lógica de lanzamientos programados para adoptar un modelo donde la inteligencia artificial se despliega de manera continua a través del ecosistema digital y físico.

Gemini 2.5, en sus versiones Flash y Pro, encabezó la evolución, marcando el ritmo en herramientas para desarrolladores, experiencias inmersivas, búsqueda avanzada y producción de contenidos.

Lee todo lo que quieras, donde vayas, contenidos exclusivos por una mínima cuota mensual. Solo en RedUSERS PREMIUM: SUSCRIBETE!