Sergey Brin, uno de los fundadores de Google, no tuvo problemas en reconocer que el lanzamiento de Gemini no había sido afortunado. “Claramente nos equivocamos con la generación de imágenes. Creo que ocurrió principalmente porque no realizamos todas las pruebas que debíamos haber hecho. El resultado, por muy buenas razones, hizo enojar a mucha gente”.

El comentario se dio en un encuentro con emprendedores en la AGI House, una organización para el desarrollo de la tecnología de inteligencia artificial, en California.

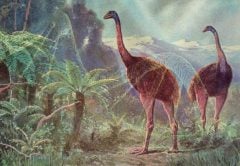

Gemini tiene problemas para entender el contexto histórico cuando produce imágenes

Palabras de peso

Aunque Brin no ocupa actualmente un cargo ejecutivo en Alphabet es parte de su junta directiva y es el principal accionista de la empresa. Su participación en la compañía está fuertemente vinculada al campo de las IA. Quizás por este motivo en varias ocasiones destacó que sus respuestas solo reflejaban sus opiniones personales.

Opiniones personales, pero públicas y de gran peso.

Brin también señaló: “Todavía no hemos descubierto porqué tiende a la izquierda en muchos casos. No es nuestra intención”. Luego explicó que Gemini no era el único modelo que tenía estos problemas. ChatGPT y Grok también dicen en ocasiones cosas muy raras que parecen ser de extrema izquierda.

Como nota positiva destacó una reducción en la tendencia a las alucinaciones en Gemini.

Los incidentes y la respuesta oficial

Antes de los comentarios de Brin, la compañía había publicado declaraciones de sus principales ejecutivos explicando con sumo cuidado lo ocurrido. Aunque no con demasiado detalle.

Según el jefe de búsquedas de Google, Prabhakar Raghavan, los problemas se dieron por dos factores. “Primero, nuestra configuración para que Gemini mostrara un amplio rango de personas falló en los casos en los que claramente no debería mostrar un rango. Segundo, al pasar el tiempo el modelo se volvió mucho más reacio de lo que queríamos y comenzó a negarse a responder a ciertas consignas. Interpretaba ciertos textos que no eran problemáticos como sensibles. Esto llevó a un modelo que sobrecompensaba en algunos casos, y era muy conservador en otros, lo que llevó a la producción de imágenes que eran vergonzosas y erróneas”.